ResNet (1/4) 発明の概要

はぐれ弁理士 PA Tora-O です。今回のテーマとして、ディープラーニングで頻出の ResNet を題材に取り上げていきます。

背景

階層型ニューラルネットワークにおける学習パラメータの更新手法として、誤差逆伝播法(Back Propagation)がよく用いられます。この手法は、入力→出力の流れとは逆方向に(出力→入力の流れで)更新量が計算される点に特徴があり、厳密解を求める場合と比べて、更新に要する計算量が大幅に削減されるというメリットがあります。

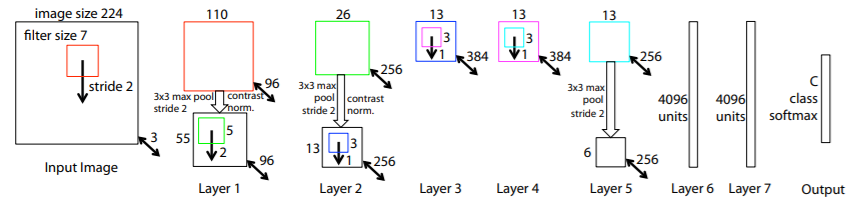

ところで、Alexnet(Krizhevsky et al)の登場以来、ネットワークの階層をより深くという設計思想が主流になりました。例えば、ILSVRC(ImageNet Large Scale Visual Recognition Challenge)コンペティションで好成績を収めたモデルに関して、AlexNet(2012)=8層、ZFNet(2013)=8層、VGGNet(2014)=19層、GoogLeNet(2014)=22層でそれぞれ構成されます。参考のため、図1に、ZFNet のネットワーク構成を示しています。

出展:Visualizing and Understanding Convolutional Networks

問題の所在

しかしながら、この誤差逆伝播法を用いて結合重みを更新する際、勾配消失(Vanishing Gradients)が大きな問題になります。「勾配消失」とは、逆伝播の過程において誤差の勾配が消失し、入力層付近での学習が進みにくくなるディープラーニング特有の問題を意味します。この現象は、ネットワークの階層が深くなるにつれて、より顕在化することが容易に想像できます。

解決手段

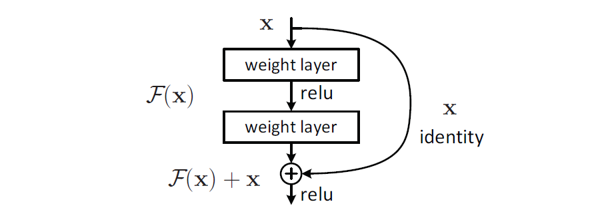

そこで、上記した問題を解決すべく、Kaiming He 氏らにより、ResNet(Residual Network) が提案されました。このアイディアを導入することで、今まで20程度に留まっていた層数を、152層!と大幅に増やすことが可能になりました。この ResNet の基本構成は、次の図2に示す通りです。一目、非常にシンプルな構成のように思われます。

出展:Deep Residual Learning for Image Recognition

以上、今回(第1回)は、ResNet の概要について説明しました。次回(第2回)は、ResNet の実施例について検討していきます。

↓ブログランキングに参加しています。よろしければ1クリックお願いします。

ディスカッション

コメント一覧

まだ、コメントがありません