ResNet(3/4)Residual Block の改良例

はぐれ弁理士 PA Tora-O です。前回(第2回)では、ResNet の実施例および作用効果について説明しました。改めて復習されたい方は、こちらのリンクから確認をお願いします。今回(第3回)は、Residual block の改良例について検討します。

残差関数の集約

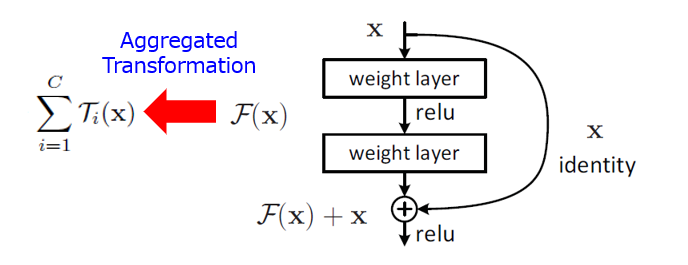

Residual block は、残差特徴量(=出力特徴量-入力特徴量)を生成する第1演算部と、残差特徴量に対して入力特徴量を加算する第2演算部と、から構成されます。第1演算部の入出力特性を示す残差関数 F(・) は、単体の関数(あるいは合成関数)で表現されていますが、複数系統のサブ関数を加算した集約関数(Aggregated Function)であっても構いません。

この考え方を踏まえて、ResNet の発表後に残差関数の改良例が次々に提案されました。ここでは、代表的な2つのモデルについて簡単に説明します。

Inception-ResNet

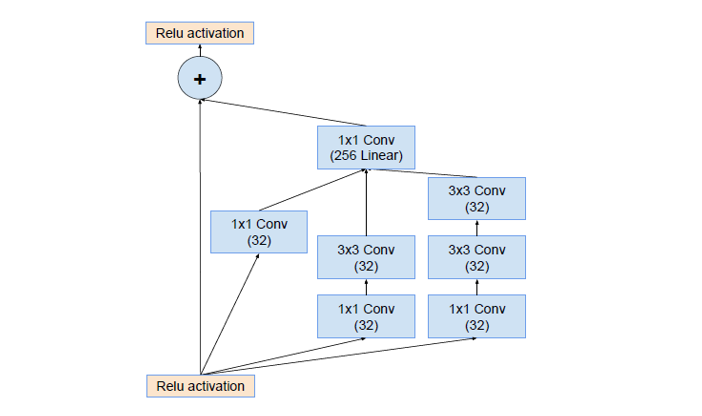

Inception-ResNet(Inception-v4)は、Christian Szegedy 氏らの研究グループによって提案されたモデルです。このモデルは、簡単に言えば、GoogLeNet の「Inception module」に ResNet の概念を取り入れたものです。なお、Inception module は、マルチスケールの畳み込み演算の分岐・結合を組み合わせたモジュールであり、これにより特徴マップの設計自由度が高くなるという利点があります。

出展:Inception-v4, Inception-ResNet and the Impact of Residual Connections on Learning

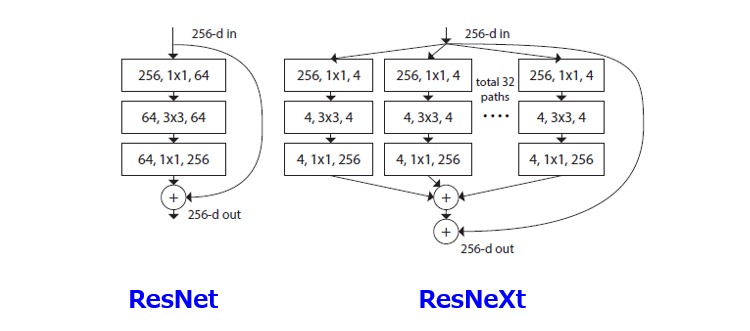

ResNeXt

ResNeXt は、ResNet と同様に、Kaiming He 氏らの研究グループによって提案された改良モデルです。このモデルによれば、同種(homogeneous)かつ多重分岐(multi-branch)の構造を採用することで、ネットワークの簡素化および演算の高速化を実現しています。本論文では、残差関数を構成する分岐数を「濃度」(Cardinality;Ⅽ)と呼んでおり、例えば Ⅽ=32(入力チャンネル総数の約数)に設定されています。

出展:Aggregated Residual Transformations for Deep Neural Networks

以上、今回(第3回)は、Residual block の改良例について解説しました。テーマ最終回(第4回)は、上記した改良例を含むクレームを作成した上で全体を総括します。

↓ブログランキングに参加しています。よろしければ1クリックお願いします。

ディスカッション

コメント一覧

まだ、コメントがありません