YOLO(1/4)発明の概要

はぐれ弁理士 PA Tora-O です。今回のテーマとして、物体検出の一手法であるYOLOを題材に取り上げていきます。

背景

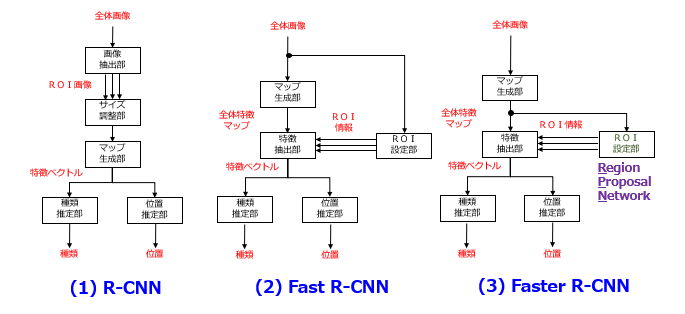

畳み込みニューラルネットワーク(CNN)を導入した物体検出手法の一例として、[1]R-CNN(Regions with CNN features)、[2]Fast R-CNN、[3]Faster R-CNN が挙げられます。各モデルの詳細については、以下の事例検討が参考になります。

事例 #005 R-CNN

事例 #007 Fast R-CNN

事例 #008 Faster R-CNN

これらモデルの共通点は、[1]関心領域(ROI;Region Of Interest)の提案機能と、[2]物体の検出機能が独立して設けられることです。この類の検出器は、“Two-stage detector” と呼ばれています。

問題の所在

ところが、Two-Stage Type の物体検出では、対象物を含み得る関心領域の候補を多数(R-CNN論文の例では、約2000個!)提案した後、検出機能の側でより高精度な検出を行っています。そのため、ROIの個数が増加するにつれて、すべての検出結果を得るまでの時間が掛かるという問題が生じます。Faster R-CNN のように、提案機能(Region Proposals)をニューラルネットワークで実装することで処理時間が大幅に短縮されましたが、リアルタイム性が実現できるレベルとはまだ言えません。

解決手段

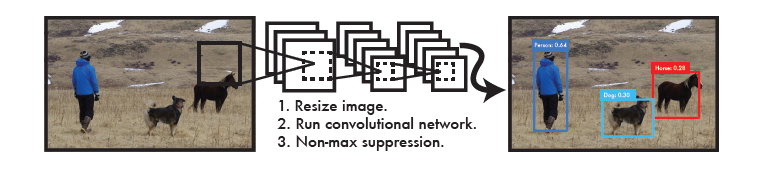

そこで、上記した問題を解決すべく、YOLOが Joseph Redmon 氏らによって提案されました。YOLOは、”You Only Look Once” の略であり、上記した提案機能および検出機能を1つのネットワークに統合した “One-stage detector” を示唆しています。

出展:You Only Look Once; Unified, Real-Time Object Detection

本論文によれば、NVIDIA社の Titan X GPU を用いた場合、通常版アルゴでは45fps(Frames Per Second)、高速版アルゴでは150fpsでリアルタイムの検出処理を行えるようです。

以上、今回(第1回)は、YOLOの概要について説明しました。次回(第2回)は、YOLOの実施例について説明します。

↓ブログランキングに参加しています。よろしければ1クリックお願いします。

ディスカッション

コメント一覧

まだ、コメントがありません