全体平均プーリング(5/5)別のアプローチ

はぐれ弁理士 PA Tora-O です。前回(第4回)では、とりあえずGAPの総括を行いました。改めて復習されたい方は、こちらのリンクから確認をお願いします。

真の発明ストーリー

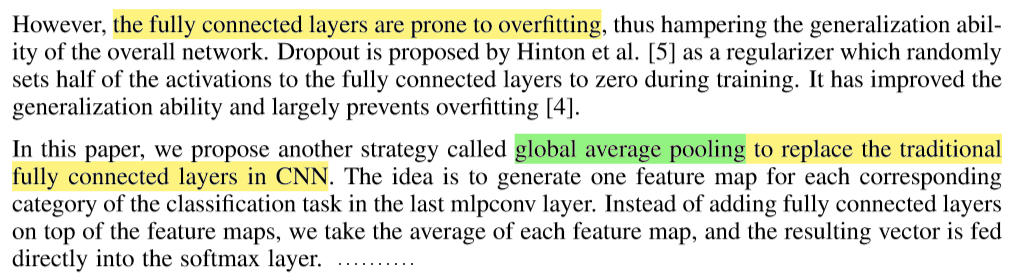

これまで述べた内容にはそれなりに信憑性が認められますが、実は、GAPの導入経緯が実際と異なっています。以下、GAPの出展であるNIN(Network In Network)の論文を一部引用します(図1)。

【図1】“Network In Network" から一部引用

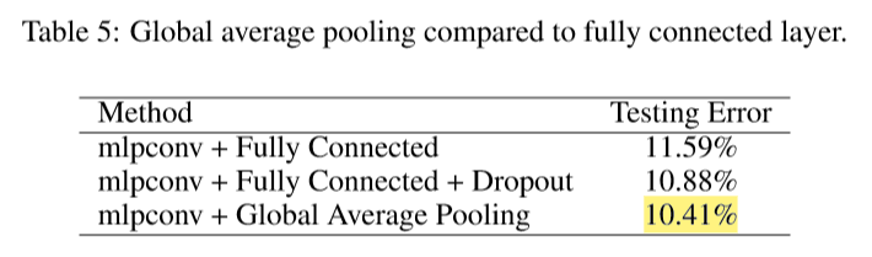

このように、本来の導入目的は、特徴マップに含まれる情報量を意図的に削減し、ネットワーク階層の増加に伴う過学習(overfitting)を抑制することです。その結果、「P層+FC層」を「GAP層」に置き換えても、ほぼ同等の認識結果が得られたとのことです(図2)。

【図2】”Network In Network” から一部引用

なお、最新手法のベース技術になっている“ResNet”(Residual Network)には、FC層が設けられていません。つまり、前回(第4回)で提案したクレームが、最新のバリエーションをカバーできないことになります。その理由は、ソフトマックス層のみならなる後段演算部は、学習パラメータを必要としないので「学習器」とは呼べないからです。

そこで、従来型のみならず最新型も広くカバーしたクレームの別解を示します。ただ、前回(第4回)で述べたような作用・効果が主張できない点に留意すべきです。

クレームの別解

入力情報に対する認識結果を出力するニューラルネットワークを構築可能に構成され、

ニューラルネットワークは、入力から出力までの間で、

入力情報に対して畳み込み演算およびプーリング演算を繰り返して実行することで、チャンネル毎のマップを生成し、

マップを構成する全ての要素値に対して統計処理を施すことで、単一値からなる特徴量をチャンネル毎に生成することを特徴とする情報処理装置。(183文字)

作者コメント

今回の事例検討では、結論の方向性を決めるのに悩みました。その理由は、GAPの本来の導入目的には、研究上の意義が確かに認められるものの、特許的な価値が主張しにくいからです。そもそも、過学習が起こらないようにするのであれば、特徴マップのサイズを小さくする代わりに、ネットワークの層数を減らせば済む話です。このように、ニューラルネットワークのどの部分に学習パラメータを振り分けるか、という設計上の問題として捉えてしまうと、どうしてもGAPの特許性が低いという結論に至ります。

そこで、今回は、前段演算部と後段演算部の関係性に着目し、一方(後段演算部)で発生する問題を他方(前段演算部)の工夫によって解決する、という考え方を取り入れて結論を出してみました。このように、問題や課題がありふれており、従来技術との差異が小さい場合、従来技術との差別化が図れるように発明ストーリーの流れを改変することは有効な手段の1つであると考えます。ただ、発明者の提案に対して独自の判断で改変を行う場合、発明者に対する説明責任(Accountability)が伴う点に注意しましょう。さすがに、AIのようにブラックボックスでも許されるという訳にはいかないです。

以上をもちまして、全体平均プーリング(GAP)の事例検討を終了します。次回から、また別のテーマに移ります。

↓ブログランキングに参加しています。よろしければ1クリックお願いします。

ディスカッション

コメント一覧

まだ、コメントがありません