Doc2Vec(2/5)PV-DBOW<前編>

はぐれ弁理士 PA Tora-O です。前回(第1回)では、Doc2Vec の概要について説明しました。改めて復習されたい方は、こちらのリンクから確認をお願いします。今回(第2回)は、Doc2Vec を構成する2種類のモデルのうち、PV-DBOW(Distributed Bag of Words version of Paragraph Vector)の概要について説明します。

問題の設定

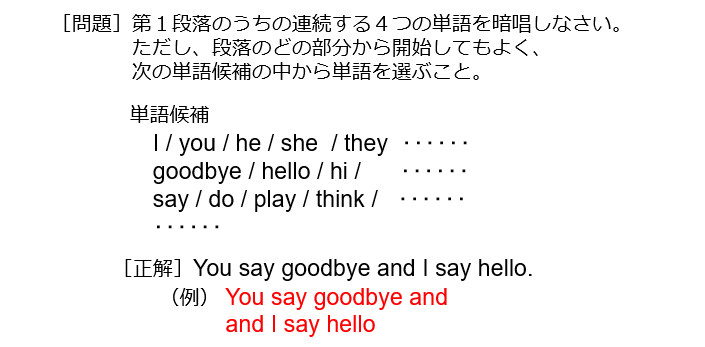

PV-DBOWモデルでは、図1に示す暗唱問題について取り組みます。

より身近な問題に置き換えると、曲名を挙げて好きなパートを歌わせるというイメージでしょうか。実際の試験問題では紙面スペースなどの都合から選択肢が狭まっていますが、ここでは、データベースに登録されているすべての段落(N個)を構成するすべての単語(M個)の中から選択され得ることにします。

ネットワーク構造

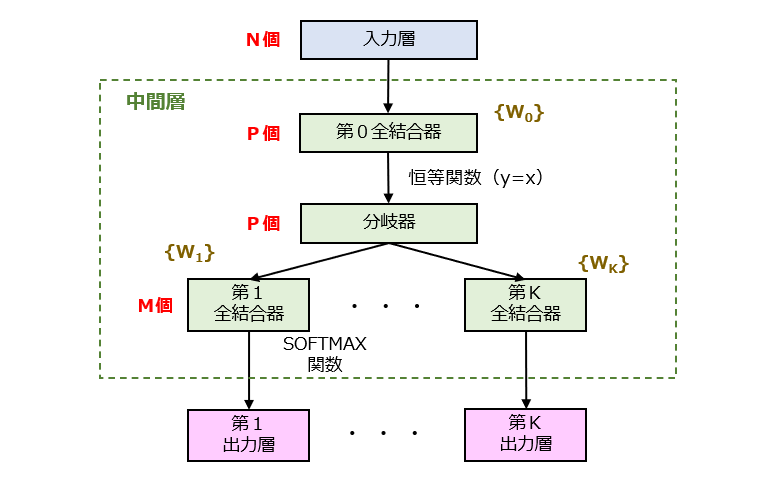

続いて、PV-DBOWモデルのネットワーク構造を図2に示します。

入力層のユニット数を「N」、中間層の入力側ユニット数を「P」、出力層のユニット数を「M」とするとき、N>PかつM>Pの関係を満たすように設計されています。ちなみに、分岐器は、第0全結合器(Fully-Connected)からのP個の出力値を複製した後、第1~第K全結合器に向けてそれぞれ出力します。

Paragraph Vector の獲得

このように構築されたPV-DBOWモデルを用いて、上記した暗唱問題を解くことができます。しかし、本来の目的は、段落の分散表現(論文で言うところの “Paragraph Vector”)を獲得することにあります。

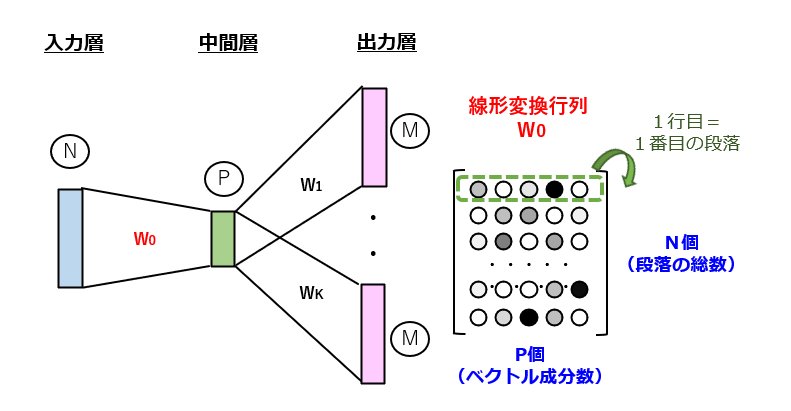

図3に示すように、学習を通じて計算された結合重みのセット、つまり線形変換行列{W0}(N×P行列)のうち、任意の行を抜き取ることで、各々の段落に対応するP次元ベクトルを求めることができます。このあたりの要領は、Word2Vec とほぼ同じです。

素朴な疑問

このように、PV-DBOWは、入力側を1個の段落ID(Paragraph ID)とし、出力側をK個の単語ID(Word ID)とする、比較的単純な学習モデルであることを確認しました。ここで、素朴な疑問が浮かんできます。例えば、1つの段落がS個の単語で構成される場合、1つの段落につき(S-K+1)個の正解が存在します。つまり、入出力の関係が、1:1ではなく、1:(S-K+1)となるので、出力側の「正解」をどのように教示すればよいのか、大変気になるところです。

以上、今回(第2回)は、PV-DBOWモデルの概要について説明しました。次回(第3回)は、このモデルの学習方法について補足した後にクレーム骨子の作成を試みます。

↓ブログランキングに参加しています。よろしければ1クリックお願いします。

ディスカッション

コメント一覧

まだ、コメントがありません