Pix2Pix(1/4)発明の概要

はぐれ弁理士 PA Tora-O です。今回のテーマとして、GANを用いた画像生成モデルで有名な “Pix2Pix” を題材に取り上げていきます。

背景

Ian Goodfellow 氏が提案した敵対的生成ネットワーク(GAN)は、データの真贋判定を行う弁別器(Discriminator)と協働して生成器(Generator)を学習させる、という単純かつ斬新な手法です。この元祖GANは、再現精度の高さという観点で十分な価値が見出せます。

その後、間もなく、GANの上位概念とも言えるCGAN(conditional GAN)が提唱されました。このCGANは、様々な条件(Condition)を付与することで生成データを修飾するという新しいコンセプトに基づきます。これにより、生成器を通じて、GANをベースにデータを変換するという新たな展開が生まれました。

発明の概要

そのような研究の潮流の中で、Phillip Isola 氏らによって画像生成モデル “Pix2Pix” が提案されました。提唱モデルに “—2—” と名付ける傾向は、自然言語処理(NLP)の分野で多くみられます。例えば、Word2Vec は、単語をベクトルに変換するモデルであることが一目で想像できます。

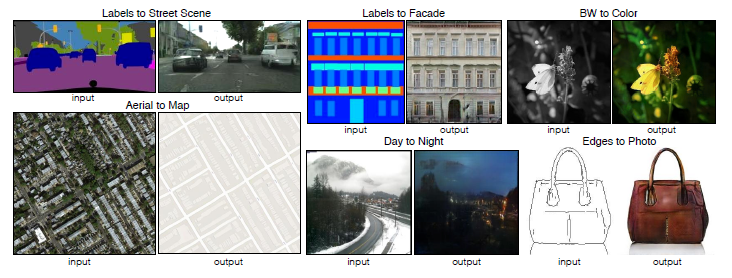

その解釈ルールに従うと、Pix2Pix は、画素から(From pixel)画素に(To pixel)変換するモデルとなります。ところが、生成器の内部では、画素値を1対1で変換するような単純な演算を行っている訳ではないため、本モデルは、厳密に言えば、画像サイズが不変の Image-to-Image 変換に該当します。あくまでも当方の想像ですが、本モデルの提唱者は、画素単位の緻密な変換ができるという意味を込めて、 Img2Img ではなく Pix2Pix と命名したのかもしれません。

出展:Image-to-Image Translation with Conditional Adversarial Networks

ところで、本記事のアイキャッチは、同論文内で紹介があった “edges2cats” の猫パンを使っています(カビではありません)。このアプリは、手書き入力された線画(エッジ)から猫画像を自動的に生成するものです。ちなみに、アイキャッチの猫パン画像は、AIが創作した画像なのでAI著作物に相当します。そういえば、論文に掲載されたAI著作物については、引用形式で転載する必要があるのでしょうか? 法律の解釈がよくわからないので、デモURLだけ示しておきます(汗)。

リンク:Image-to-Image Demo (edges2cats etc.)

次回までの検討課題

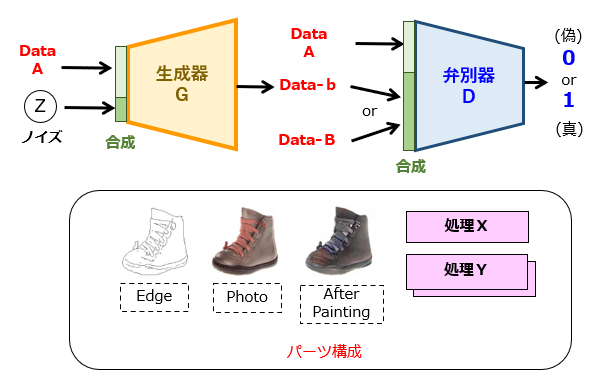

続いて、Pix2Pix の具体的なネットワーク構成について説明する前に、次回までの検討課題を出してみましょう。以下の基本モデル(CGAN)に必要なパーツ構成を埋め込んで、pix2pix モデルを完成させてください。

図2の上側には、CGANの構成の基本形を示しています。一方、図2の下側には、パーツ構成を列挙しています。なお、「処理X」、「処理Y」は、どのような演算処理が必要かを検討した上で、それぞれ適切な箇所に配置してください。

以上、今回(第1回)は、Pix2Pix の概要について説明しました。次回(第2回)は、Pix2Pix の実施例について説明します。

↓ブログランキングに参加しています。よろしければ1クリックお願いします。

ディスカッション

コメント一覧

まだ、コメントがありません