Negative Sampling(4/4)総括

はぐれ弁理士 PA Tora-O です。前回(第3回)では、“Negative Sampling” の作用効果について検討しました。改めて復習されたい方は、こちらのリンクから確認をお願いします。今回は、過去3回分の検討を踏まえ、発明ストーリーの一例を提示します。仕事ではないのでやや雑に書きますがご了承ください。

発明ストーリー

【従来技術】

最近、連続する単語の配列パターンをニューラルネットワークに学習させ、得られた結合重み行列から単語の分散表現を獲得する手法(例えば、CBOWモデル)が提案されている。この類のニューラルネットワークには、N個の単語群に対応するラベル集合を入出力するためのN個の演算ユニットからなる入出力層が設けられる。このため、ニューラルネットワークは、学習の度に、単語の総数(=N)に略比例する荷重和演算を実行する。

【問題点と課題】

問題点は、単語の総数が多くなるにつれて荷重和演算が増加し、学習の終了までに要する時間が掛かってしまうこと。

課題は、単語の総数が多い場合において、学習の終了までに要する時間を短縮すること。

【クレーム骨子】(Negative Sampling)

N個の単語群に対応するラベル集合を入力するN個の演算ユニットからなるm層の入力層、

1層以上の中間層、及び

N個の単語群に対応するラベル集合を出力するN個の演算ユニットからなる(M-m)層の出力層

が全結合により順次接続されたニューラルネットワークに対して、M個の連続する単語同士の関係性を学習させる方法であって、

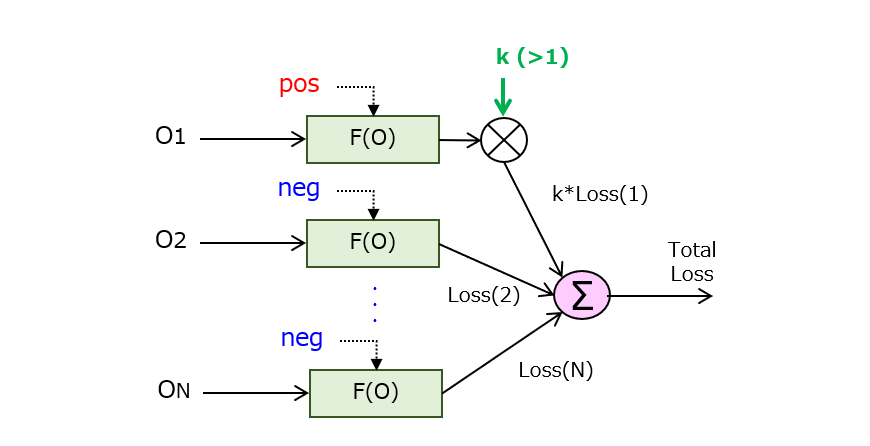

学習に用いられる教師データ毎に、

各々の出力層を構成するN個の演算ユニットを、正例に対応する1個の正例ユニットと、負例に対応する(N-1)個の負例ユニット群とに分類し、

負例ユニット群の一部のみが除外されたニューラルネットワークに対して学習を行うことを特徴とする学習方法。(288文字)

【作用と効果】

(N-1)個の負例ユニット群の一部のみが除外されたニューラルネットワークを用いることで、除外を行わない場合と比べて、1回の学習処理に伴い実行される荷重和演算の回数が削減されるとともに、単語の標本数に占める正例の割合が相対的に増加する。つまり、正例と負例の割合に関する不均衡が是正され、正例による学習への寄与度が高くなるので、その分だけ学習の効率が向上する。これにより、単語の総数が多い場合において、学習の終了までに要する時間が短縮される。

作者コメント

(1)別の実施例

上記したクレーム骨子では、「負例ユニット群の一部のみ(が)除外」とあえて表現することで、緑色のマーカ箇所の作用(=荷重和演算の回数削減)が生じ、その結果、本発明の効果(=学習時間の短縮)を強調することができます。ところが、「正例による学習への寄与度を高くする」点に着目するのであれば、当初発明の趣旨からやや逸れ気味ですが、次の図に示すような実施例も一応考えられます。

「演算ユニットの除外」のみならず、この実施例を含めようと試みる場合、クレーム表現をどのように変更したらよいでしょうか。もし興味があったら検討してみてください。

(2)他の処理への適用可能性

既に気づいた方もいるかもしれませんが、この “Negative Sampling” は、自然言語処理(NLP)以外に、画像認識を含む様々な分類問題にも適用できます。そうすると、上記したクレーム骨子のうち、ニューラルネットワークの構成について再考する余地がありそうです。

以上をもちまして、“Negative Sampling” の事例検討を終了します。次回から、また別のテーマに移ります。

↓ブログランキングに参加しています。よろしければ1クリックお願いします。

ディスカッション

コメント一覧

まだ、コメントがありません